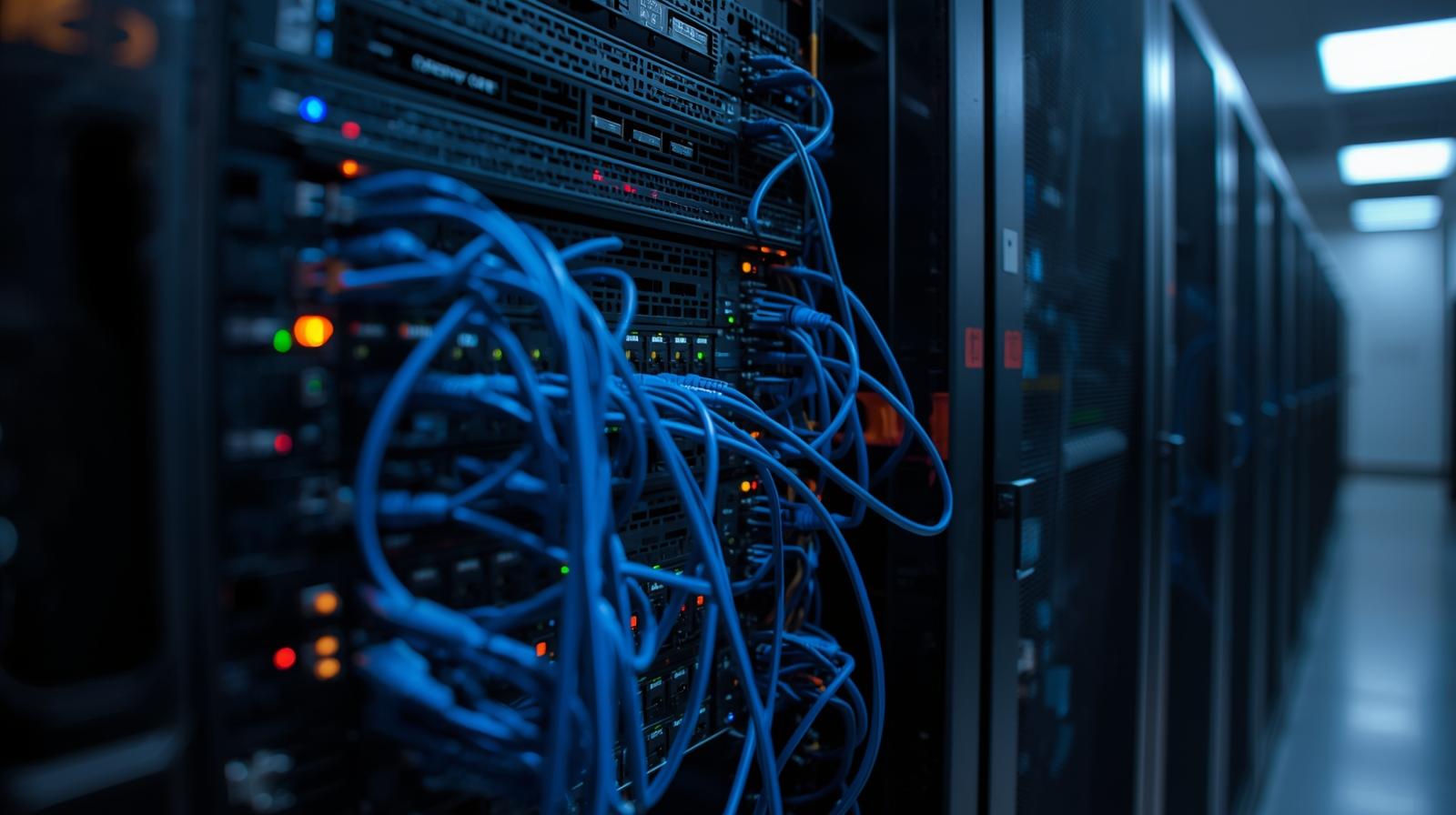

En los últimos años, la inteligencia artificial ha dejado de ser un concepto futurista para convertirse en una herramienta real que utilizamos cada día: desde asistentes virtuales hasta modelos de generación de texto, imágenes o voz. Aunque la mayoría de estas tecnologías se usan a través de la nube, cada vez más personas quieren experimentar con IA en local, ya sea por privacidad, velocidad o simple curiosidad técnica.

La buena noticia es que hoy es posible montar en casa un pequeño servidor y ejecutar modelos de IA sin depender de terceros. En este artículo te explico los pasos clave para hacerlo.

¿Por qué instalar una IA en local?

Antes de lanzarte a montar tu servidor, conviene saber qué ventajas tiene:

- Privacidad: tus datos no salen de tu red.

- Independencia: no dependes de servicios externos ni de sus políticas.

- Velocidad: al estar en tu máquina, las respuestas son inmediatas.

- Aprendizaje: configurar y ejecutar modelos te da experiencia muy valiosa.

Requisitos básicos de hardware

La inteligencia artificial, especialmente los modelos de última generación, consume muchos recursos. Para empezar, piensa en lo siguiente:

- CPU potente (mínimo 8 núcleos recomendados).

- GPU dedicada con soporte CUDA (NVIDIA es la más compatible para IA). A partir de 8-12 GB de VRAM ya se puede trabajar con modelos medianos.

- RAM: al menos 16 GB, aunque 32 GB es lo ideal.

- Almacenamiento SSD: los modelos ocupan decenas de GB, así que lo rápido es mejor.

💡 Consejo: si no tienes un PC con estas características, puedes montar un servidor casero con una torre reciclada y mejorarle solo la gráfica y la RAM.

Software y entorno necesario

Una vez tengas el hardware, hay que preparar el software:

- Sistema operativo: Ubuntu o Debian suelen ser más estables para servidores de IA.

- Drivers de GPU: asegúrate de instalar los controladores correctos para tu gráfica.

- Entorno Python: casi todos los frameworks de IA corren sobre Python.

- Frameworks recomendados:

- PyTorch o TensorFlow para modelos de deep learning.

- Hugging Face Transformers si quieres probar modelos de texto (GPT, LLaMA, etc.).

- AUTOMATIC1111 / Stable Diffusion si lo tuyo es la generación de imágenes.

Ejemplo práctico: instalar un modelo de texto local

Supongamos que quieres probar un modelo estilo ChatGPT pero en tu ordenador:

- Crea un entorno virtual en Python:

python3 -m venv ia-local source ia-local/bin/activate - Instala las librerías:

pip install torch transformers accelerate - Descarga un modelo desde Hugging Face (ejemplo LLaMA 2 o GPT-J).

from transformers import pipeline pipe = pipeline("text-generation", model="EleutherAI/gpt-j-6B") print(pipe("Hola, ¿puedes ayudarme con un ejemplo en local?", max_length=50))

En pocos minutos tendrás a tu IA respondiendo directamente desde tu servidor casero.

Consejos para sacarle partido

- Usa Docker si quieres encapsular entornos y evitar conflictos.

- Habilita acceso remoto (por ejemplo vía web UI) para usar tu IA desde otros dispositivos en casa.

- Optimiza: si tu GPU no es muy potente, usa técnicas como quantization (reducir tamaño del modelo).

- Mantén copias: los modelos cambian rápido, descarga y guarda versiones estables.

¿Qué limitaciones encontrarás?

- Consumo energético: un servidor encendido 24/7 gasta luz.

- Modelos muy grandes: no podrás correr los de última generación si no tienes hardware avanzado.

- Curva de aprendizaje: necesitarás algo de paciencia al configurar dependencias.

Montar un servidor de IA en local ya no es exclusivo de grandes laboratorios. Con un PC decente, algo de tiempo y muchas ganas, puedes tener tu propio asistente inteligente o tu motor de generación de imágenes en casa.

La clave está en empezar poco a poco: probar con modelos pequeños, aprender cómo funcionan y escalar según tus necesidades.